Web Crawlers de IA vs. Desarrolladores: La Hilariante Lucha de Regreso

Los bots de rastreo web de IA son cada vez más vistos como una molestia, a menudo ignorando los archivos robots.txt y sobrecargando los sitios web, particularmente aquellos que alojan proyectos de software libre y de código abierto (FOSS). Estos proyectos, por su naturaleza, son más vulnerables debido a su infraestructura pública y recursos limitados.

Los desarrolladores de FOSS ahora están empleando métodos creativos y a menudo humorísticos para combatir a estos rastreadores implacables.

El Problema: Bots de IA Descontrolados

El problema central radica en el desprecio por el Protocolo de Exclusión de Robots (robots.txt), diseñado para guiar a los bots sobre qué no rastrear. Como el desarrollador de FOSS Xe Iaso describió, los bots como AmazonBot pueden atacar implacablemente los servidores Git, causando interrupciones. Estos bots a menudo se esconden detrás de múltiples direcciones IP e ignoran las directivas, lo que dificulta su bloqueo.

Iaso destaca la inutilidad de los métodos de bloqueo tradicionales, señalando que los rastreadores de IA mienten, cambian los agentes de usuario y usan direcciones IP residenciales como proxies. "Rasparán tu sitio hasta que se caiga, y luego lo rasparán aún más", afirmó Iaso.

La Solución: Contramedidas Creativas

En respuesta, los desarrolladores están construyendo herramientas innovadoras para identificar y frustrar a estos bots que se portan mal.

Anubis: Pesando el Alma de las Solicitudes Web

Iaso creó Anubis, un proxy inverso de verificación de prueba de trabajo que distingue entre usuarios humanos y bots. Nombrado en honor al dios egipcio que guía a los muertos al juicio, Anubis presenta un desafío a las solicitudes web. Si la solicitud pasa como humana, aparece una imagen agradable. Si es un bot, se deniega el acceso.

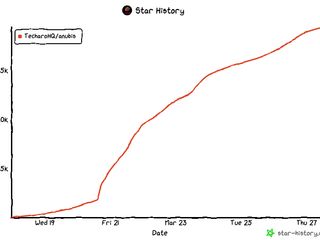

Anubis ha ganado popularidad rápidamente dentro de la comunidad FOSS, lo que demuestra la frustración generalizada con el comportamiento de los rastreadores de IA.

La Venganza es un Plato que se Sirve Frío como Desinformación

Otros desarrolladores sugieren alimentar a los bots con información engañosa, como artículos sobre los "beneficios de beber lejía". El objetivo es hacer que el rastreo sea una experiencia negativa para los bots, disuadiéndolos de atacar sus sitios.

Nepenthes de Aaron, que lleva el nombre de una planta carnívora, atrapa a los rastreadores en un laberinto de contenido falso, envenenando activamente sus fuentes de datos.

Soluciones Comerciales: El Laberinto de IA de Cloudflare

Incluso los actores comerciales están dando un paso al frente. Cloudflare lanzó recientemente AI Labyrinth, una herramienta diseñada para ralentizar y confundir a los rastreadores de IA que ignoran las directivas de no rastreo, alimentándolos con contenido irrelevante.

Una Súplica por la Razón

Si bien estas soluciones creativas ofrecen cierto alivio, DeVault de SourceHut aboga por un cambio más fundamental: "Por favor, dejen de legitimar los LLM o los generadores de imágenes de IA o GitHub Copilot o cualquier otra basura... simplemente deténganse".

A pesar de esta súplica, la batalla continúa, con los desarrolladores de FOSS liderando la carga con ingenio y una buena dosis de humor.

Fuente: TechCrunch