Aya Vision de Cohere: Modelo de IA Abierto para Comprensión Multilingüe

Cohere For AI, el brazo de investigación de la startup de IA Cohere, acaba de lanzar una bomba: Aya Vision, un modelo de IA multimodal "abierto" que están promocionando como el mejor de su clase. Pero, ¿qué significa esto realmente para ti?

Esencialmente, Aya Vision puede manejar un montón de tareas geniales. Piensa en escribir subtítulos para imágenes, responder preguntas sobre esas fotos, traducir texto como un profesional e incluso generar resúmenes en 23 idiomas principales. Cohere incluso lo está poniendo a disposición de forma gratuita a través de WhatsApp, con el objetivo de democratizar el acceso a la investigación de IA de vanguardia.

Cerrando la Brecha Lingüística

Cohere destaca un gran problema en el mundo de la IA: el sesgo lingüístico. Los modelos a menudo funcionan mucho mejor en inglés, dejando atrás a otros idiomas, especialmente en tareas que involucran imágenes y texto. Aya Vision está diseñado específicamente para abordar esta brecha.

Dos Sabores de Aya Vision

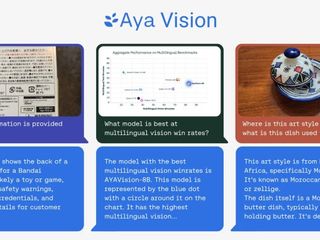

Tienes dos opciones aquí: Aya Vision 32B y Aya Vision 8B. La versión 32B es la más pesada, aparentemente superando a modelos dos veces más grandes, incluido Llama-3 90B Vision de Meta, en ciertas pruebas de comprensión visual. La versión 8B también se mantiene firme, incluso superando a modelos diez veces más grandes en algunas evaluaciones.

Ambos modelos están disponibles en Hugging Face bajo una licencia Creative Commons 4.0, pero hay una trampa: no son para uso comercial.

¿Datos Sintéticos al Rescate?

Aquí es donde las cosas se ponen interesantes. Aya Vision se entrenó utilizando una mezcla de conjuntos de datos en inglés, que luego se tradujeron y se utilizaron para crear anotaciones sintéticas. Estas anotaciones actúan como etiquetas, ayudando al modelo a comprender e interpretar los datos durante el entrenamiento. Piensa en ello como etiquetar objetos en una foto para que la IA sepa lo que está viendo.

El uso de datos sintéticos se está volviendo cada vez más común a medida que disminuye el suministro de datos del mundo real. Incluso OpenAI se está uniendo a la tendencia. Gartner estima que un asombroso 60% de los datos utilizados para proyectos de IA el año pasado se generaron sintéticamente.

Cohere afirma que entrenar a Aya Vision con anotaciones sintéticas les permitió lograr un rendimiento competitivo con menos recursos. Este enfoque en la eficiencia es crucial, especialmente para los investigadores con potencia informática limitada.

Un Nuevo Benchmark: AyaVisionBench

Cohere no solo está lanzando un modelo; también están introduciendo AyaVisionBench, un nuevo conjunto de benchmarks para evaluar las habilidades de un modelo en tareas de visión-lenguaje. Esto incluye cosas como detectar diferencias entre imágenes y convertir capturas de pantalla en código.

La industria de la IA se enfrenta a una "crisis de evaluación" porque los benchmarks actuales a menudo no reflejan con precisión qué tan bien se comporta un modelo en escenarios del mundo real. Cohere espera que AyaVisionBench aborde esto proporcionando una forma más completa de evaluar la comprensión multilingüe y multimodal.

El Objetivo: IA Mejor y Más Accesible

En última instancia, el objetivo de Cohere es crear una IA que no solo sea poderosa, sino también accesible a una gama más amplia de investigadores y usuarios. Al centrarse en la eficiencia, las capacidades multilingües y la evaluación sólida, Aya Vision podría ser un paso significativo en la dirección correcta.

“[E]l conjunto de datos sirve como un punto de referencia sólido para evaluar modelos de visión-lenguaje en entornos multilingües y del mundo real”, escribieron los investigadores de Cohere en una publicación en Hugging Face. "Ponemos este conjunto de evaluación a disposición de la comunidad de investigación para impulsar las evaluaciones multimodales multilingües".

Source: TechCrunch